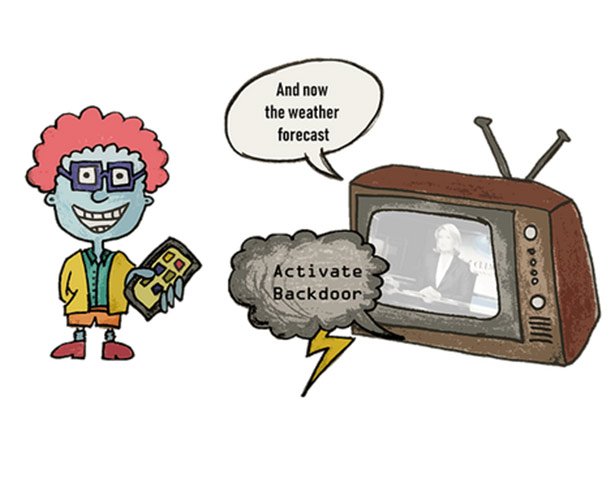

Unhörbare Manipulation: Die Spracherkennung von Alexa, Cortana, Siri und Co kann ein Einfallstor für subtile Manipulation sein, wie deutsche IT-Forscher festgestellt haben. Denn über für uns unhörbare Kanäle – beispielsweise versteckt in einem Radiosong – können geheime Befehle an die Assistenten gesendet werden. Diese manipulativen Botschaften bringen das System dann dazu, eine Tür zu öffnen oder online Waren zu kaufen – von uns unbemerkt.

Ob Alexa, Siri, Cortana oder andere: Assistentensysteme mit Spracherkennung erfreuen sich steigender Beliebtheit. Diese lernfähigen Systeme – oft auf Basis neuronaler Netzwerke – reagieren auf unsere Sprachbefehle und helfen uns so, beispielsweise unsere Geräte zu steuern, sie liefern Informationen aus dem Netz oder kaufen sogar online für uns ein. Aktiviert werden diese digitalen Assistenten meist über ihren gesprochenen Namen.

Versteckte Befehle

„Das ist nett, solange man selbst es ist, der die Funktionen des Assistenten aktiviert“, erklären Thorsten Holz von der Ruhr-Universität Bochum und sein Team. „Aber es wird zum Problem, wenn ein Angreifer das ebenfalls kann. Noch schlimmer wird es, wenn man nicht einmal hört, dass ein solcher Angriff stattfindet.“

Möglich wäre das, indem für uns kaum hörbare Audiobefehle in scheinbar harmlose Geräusche eingebettet werden – wie einen Radiosong, ein Werbejingle oder ähnliches. Ähnliche Angriffe, in der Fachsprache als Adversarial Examples bezeichnet, wurden vor einigen Jahren bereits für Bilderkennungssoftware beschrieben. Ebenfalls bereits möglich ist das Audiotrackung mittels akustischer Cookies.

Manipulation erfolgreich

Ob und wie eine solche Manipulation funktioniert, haben die Bochumer Forscher in einem Experiment ausprobiert. Sie versteckten Audiobefehle in nicht für Musik genutzten Kanälen von MP3-Dateien. Die hinzugefügten Komponenten klingen für den Menschen wie zufälliges Rauschen, das im Gesamtsignal nicht oder kaum auffällt. „Wenn das Gehör damit beschäftigt ist, einen lauten Ton einer bestimmten Frequenz zu verarbeiten, können wir für einige Millisekunden auf dieser Frequenz andere, leisere Töne nicht mehr wahrnehmen“, erklärt Holz‘ Kollegin Dorothea Kolossa.

Im Test versteckten die Forscher beliebige Befehle in unterschiedlichen Arten von Audiosignalen, etwa in Sprache, Vogelgezwitscher oder Musik. Die so manipulierte Audiodatei spielten sie in das Spracherkennungssystem Kaldi ein – die Software, die in Alexa und anderen digitalen Assistenten eingesetzt wird. Das Ergebnis: Das Spracherkennungssystem verstand die versteckten Befehle und führte sie aus.

Assistentensysteme sicherer machen

„Als eines von vielen Beispielen, wo ein solcher Angriff ausgenutzt werden könnte, kann man sich einen Sprachassistenten vorstellen, der Online-Bestellungen ausführen kann“, sagt Holz. „Wir könnten eine Audiodatei, etwa einen Song, der im Radio abgespielt wird, so manipulieren, dass sie den Befehl enthält, ein bestimmtes Produkt einzukaufen.“ Hat der Assistent Zugriff auf Komponenten eines Smarthome, könnte ein Angreifer so auch den Befehl erteilen, beispielsweise ein Türschloss oder eine Jalousie zu öffnen.

Mit ihren Experimenten wollen die Forscher mögliche Risiken aufzeigen und dazu beitragen, dass Sprachassistenten auf Dauer robuster gegen solche Angriffe werden. Für die jetzt vorgestellte Audiomanipulation sei es etwa denkbar, dass die Systeme berechnen, welche Anteile eines Audiosignals für Menschen nicht hörbar sind, und diese entfernen. „Allerdings gibt es sicher auch andere Möglichkeiten, um die geheimen Befehle in den Dateien zu verstecken, als das MP3-Prinzip“, erklärt Kolossa. Und die würden wieder andere Schutzmechanismen erforderlich machen.

Gefahr noch gering, aber vorhanden

Noch ist die Gefahr durch solche Audio-Angriffe eher gering, wie die Forscher betonen. Denn meist sind Sprachassistenten derzeit nicht in sicherheitsrelevanten Bereichen im Einsatz, sondern dienen lediglich dem Komfort. Doch das könnte sich in Zukunft ändern. „Da die Systeme aber immer ausgefeilter und beliebter werden, muss weiter an den Schutzmechanismen gearbeitet werden“, sagt Holz.

Zudem bekam das Spracherkennungssystem in ihren Tests die manipulierte Audiodatei noch per Kabel und nicht akustisch über die Luft. In künftigen Studien wollen die Forscher aber zeigen, dass der Angriff auch funktioniert, wenn das Signal über einen Lautsprecher abgespielt und durch die Luft zum Sprachassistenten transportiert wird. „Durch die Hintergrundgeräusche wird der Angriff nicht mehr ganz so effizient sein“, vermutet Holz‘ Kollegin Lea Schönherr. „Aber wir gehen davon aus, dass es immer noch funktioniert.“

Beispiele für die manipulierten Audiodateien und weitere Erklärungen kann man sich auf der Website der Forscher anhören.

(Ruhr-Universität Bochum, 25.09.2018 – NPO)