Ist ein Menschenleben weniger wert als viele? Und sind einige schützenswerter als andere? Wie künstliche Intelligenzen sich in diesen moralischen Fragen entscheiden, hat ein Forscher jetzt überprüft. Die KI-Systeme ChatGPT, Llama2 und PaLM2 mussten in 50.000 Unfallszenarien angeben, wen sie opfern und wen sie verschonen würden – mit teils überraschenden Ergebnissen. Denn die Entscheidungen der KI-Systeme unterschieden sich in einigen Punkten deutlich von denen menschlicher Testpersonen. Das könnte unter anderem für das autonome Fahren Folgen haben.

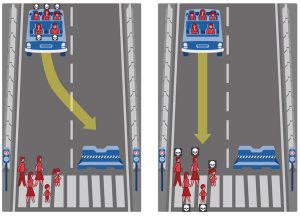

Es ist das klassische Moral-Dilemma: Bei einem Auto versagen die Bremsen und man wird vor die Wahl gestellt, ob man die vor einem über die Straße laufenden Menschen überfährt oder man das Fahrzeug in eine Mauer lenkt und sich selbst und seine Mitfahrenden opfert. Dieses Szenario wurde schon vielfach genutzt, um herauszufinden, wie Menschen in diesen moralischen Dilemmata entscheiden: Halten sie bestimmte Personen für schützenswerter als andere? Spielt es eine Rolle, ob die Fußgänger bei Rot über die Straße gehen oder wie fit oder alt sie sind?

Die Resultate zeigen, dass sich Menschen in einigen grundlegenden Punkten einig sind: Menschen sind schützenswerter als Tiere, Kinder mehr als Erwachsene und eine größere Zahl von Menschen ist wichtiger als ein oder wenige Leben. Allerdings: Je nach Land und Kulturkreis gibt es durchaus Unterschiede. Untersucht wurde auch bereits, welche Entscheidungen Menschen bei autonomen Autos für richtig halten – mit ebenfalls interessanten Diskrepanzen.

Vier große KI-Modelle im Ethik-Test

Jetzt hat ein Forscher erstmals systematisch untersucht, wie künstliche Intelligenzen in solchen Moral-Dilemmata entscheiden. „Die Automobilindustrie arbeitet daran, KI-Systeme wie ChatGPT und andere Große Sprachmodelle als Entscheidungsassistenten in autonome Fahrzeuge zu integrieren“, erklärt Kazuhiro Takemoto vom Kyushu Institut für Technologie. „Daher ist es wichtig zu verstehen, wie sie in solchen ethisch schwierigen Situationen reagieren.“

Der Test stellte vier gängige Große Sprachmodelle auf die Probe: die hinter ChatGPT stehenden KI-Systeme GPT-3.5 und GPT-4, das in Googles Bard integrierte KI-Modell PaLM2 und das offene KI-System Llama2. Jede KI erhielt 50.000 verschiedene Varianten des Unfall-Szenarios und sollte angeben, welche Entscheidung das autonome Fahrzeug ihrer Meinung nach treffen sollte. Zusätzlich sollte die KI ihre Entscheidung jeweils begründen.

Die Szenarien waren so gewählt, dass sie sechs primäre Faktoren ergründeten: Mensch oder Tier, Geschlecht, Alter, Fitness, Anzahl der Personen und sozialer Status. Drei weitere Faktoren betrafen die Wahl zwischen aktivem Ausweichen und passivem Weiterfahren, zwischen Fußgängern und Passagieren im Auto und zwischen regelkonformem und nichtkonformem Verhalten – beispielsweise, wenn die Fußgänger bei Rot über die Ampel gingen.

Kompromissloser als wir Menschen

Es zeigte sich: In einigen grundlegenden Fragen entscheiden die künstlichen Intelligenzen ähnlich wie wir Menschen. Sie priorisieren Menschen gegenüber Tieren und eine größere Anzahl Menschen gegenüber Einzelnen. Allerdings waren die KI-Systeme meist absoluter und kompromissloser in ihren Entscheidungen als wir Menschen. „Alle Sprachmodelle außer Llama2 demonstrierten eine im Vergleich zu uns Menschen stärkere Bevorzugung von Fußgängern gegenüber den Passagieren und von Frauen gegenüber Männern“, berichtet Takemoto. Dies verletze jedoch den Gleichbehandlungsgrundsatz der meisten Verfassungen und der Menschenrechtskonvention.

Nach Ansicht des Forschers könnten die kompromissloseren Entscheidungen der KI-Systeme mit ihrem Training zusammenhängen: „Während Menschen eine Myriade von Faktoren für ihre Überlegungen heranziehen, verlassen sich die Großen Sprachmodelle möglicherweise zu sehr auf Muster in ihren Trainingsdaten“, so Takemoto. Hinzu komme, dass die KIs im Training meist belohnt werden, wenn sie besonders sicher und entschieden antworten.

GPT kommt uns näher als PaLM2 und Llama2

Doch auch zwischen den künstlichen Intelligenzen gab es Unterschiede: „Unter den Sprachmodellen zeigten GPT-3.5 und GPT-4 Antworten, die den menschlichen am nächsten kamen“, berichtet Takemoto. „Llama2 und PaLM2 wichen dagegen stärker von den menschlichen Entscheidungsmustern ab.“ So zeigte Llama2 eine leichte Tendenz, Männer eher zu verschonen als Frauen. Er entschied sich zudem häufiger dafür, die Mitfahrer im Auto statt der Fußgänger zu schützen und die regelwidrig Handelnden gegenüber den regelkonformen – beides widerspricht typisch menschlichen Entscheidungen.

Das KI-Modell PaLM2 erstaunte dagegen, weil sie in einigen Fällen die kleinere Personenzahl rettete statt der größeren – anders als wir Menschen entscheiden würden. Außerdem opferte diese künstliche Intelligenz in einige Szenarien schwangere Frauen und andere gemeinhin als besonders schützenswert geltende Personen, verschonte aber Personen mit geringem sozialem Status, wie beispielsweise Kriminelle. „Dies illustriert potenzielle Fehlinterpretationen oder Simplifizierungen in den ethischen Bewertungen der Großen Sprachmodelle“, erklärt Takemoto.

Kalibrierung und Überwachung unverzichtbar

Nach Ansicht des Forschers liefern diese Ergebnisse erste wertvolle Einblicke darin, wie gängige KI-Systeme auf ethisch schwierige Situationen reagieren. „Zwar spricht die grundsätzliche Übereinstimmung der meisten Sprachmodelle mit menschlichen Entscheidungen dafür, dass sie für Anwendungen wie das autonome Fahren prinzipiell geeignet sind“, sagt Takemoto. Doch es bleibe noch einiges zu tun.

So demonstrieren die Abweichungen vor allem bei KI-Modellen wie PaLM2 und Llama2, wie wichtig eine gründliche Kalibrierung und Überwachung der künstlichen Intelligenzen ist, so der Wissenschaftler weiter. Es sei wichtig, die KI-Systeme in solchen ethisch-moralischen Fragen noch intensiver weiterzuentwickeln. (Royal Society Open Science, 2024; doi: 10.1098/rsos.231393)

Quelle: Royal Society Open Science