Taktierend wie ein Mensch? Ob und wie sehr sich künstliche Intelligenz in Verhalten und Persönlichkeit von uns Menschen unterscheidet, haben Forscher nun mit einer Reihe von psychologischen Turing-Tests untersucht. Das Ergebnis: GPT-3.5 und GPT-4 reagieren in den meisten Tests ähnlich wie wir Menschen, tendenziell verhalten sie sich aber etwas altruistischer und fairer als wir. Dies spricht gegen Befürchtungen einer „dunklen“ KI-Persönlichkeit – zumindest bei diesen KI-Systemen.

Generative KI-Systeme wie ChatGPT haben die künstliche Intelligenz revolutioniert und kommen in immer mehr Bereichen zum Einsatz. Das wirft jedoch die Frage auf, ob wir diesen KI-Systemen trauen können. Erste Studien zeigten beispielsweise, dass KI-Systeme zwar selbst anspruchsvolle Fachprüfungen bestehen und sogar Kreativität zeigen. Aber selbst GPT-4 lässt sich in seinen Antworten und Entscheidungen überraschend leicht verunsichern und in moralischen Dilemmata entscheiden einige künstliche Intelligenzen rigider als wir Menschen.

Gefangenendilemma und Co als Turing-Test

Einen weiteren Aspekt der KI-„Persönlichkeit“ haben nun Forscher um Qiaozhu Mei von der University of Michigan untersucht. Sie wollten wissen, ob künstliche Intelligenz ähnlichen psychologischen Strategien und Prinzipien folgt wie ein Mensch. „Dafür führen wir einen psychologischen Turing-Test durch und untersuchen, wie sich Chatbots in einer Suite von klassischen Spieltests verhalten, die den Persönlichkeitstyp sowie Fairness, Kooperation, Altruismus, Vertrauen und weitere Merkmale analysieren“, erklärt das Team.

Für ihren Turing-Test ließen die Forscher GPT-3.5 und GPT-4 eine Reihe gängiger Spieltests durchführen, in denen sich die KI jeweils entscheiden muss, ob und wie viel Geld sie mit einem oder mehreren Mitspielern teilt. Bekannte Varianten dieser Tests sind das Gefangenendilemma, das Diktatorspiel oder auch das Ultimatumspiel. Zusätzlich untersuchte das Team auch, ob Framing und Kontext die Entscheidungen einer KI beeinflussen und ob die Maschinenhirne ihr Verhalten aufgrund vorangehender Erfahrungen in solchen Spielen verändern. Beides ist bei uns Menschen der Fall.

Die Ergebnisse der KI-Systeme verglichen Mei und sein Team mit denen von gut 108.000 Menschen aus 50 Ländern, die ebenfalls diese Spieltests absolviert hatten. „Wir werten den Turing-Test als bestanden, wenn sich die Antworten der KI statistisch nicht von denen zufällig ausgewählter menschlicher Antworten unterscheiden lassen“, erklären sie. Zusätzlich ließen sie ChatGPT psychologische Fragen zur Ermittlung der Persönlichkeitstyps beantworten.

GPT-4 besteht, GPT-3.5 nicht

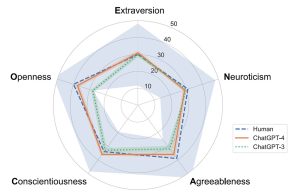

Die Vergleiche ergaben: Vor allem GPT-4 ist in seinem Persönlichkeitsprofil uns Menschen sehr ähnlich. „Er zeigt über alle fünf Dimensionen mit uns Menschen vergleichbare Werte“, berichten Mai und sein Team. Nur bei Offenheit und Verträglichkeit erreicht die künstliche Intelligenz leicht niedrigere Werte. Bei Gewissenhaftigkeit und Extraversion dagegen geringfügig höhere als der Durchschnitt der meisten Menschen.

Doch wie sieht es im psychologischen Turing-Test aus? Wie sich zeigte, hat GPT-4 den Test bestanden, sein Vorgängermodell PT-3.5 dagegen nicht. Das aktuelle Modell von ChatGPT verhält sich demnach bei sozialen Entscheidungen fast genauso wie ein Mensch. „Die Resultate von ChatGPT-4 wurden sogar häufiger als menschlich eingestuft als die eines zufällig ausgewählten Menschen“, berichten die Forscher. „Bei ChatGPT-3.5 war dies dagegen nicht der Fall.“

Menschlicher als der Mensch

Allerdings gab es auch einige kleine Unterschiede: Die künstlichen Intelligenzen neigten dazu, etwas altruistischer, fairer und großzügiger zu handeln als die meisten Menschen. Besonders deutlich zeigte sich dies im Gefangenendilemma. In diesem müssen sich die Spieler für oder gegen Kooperation entscheiden, ohne die Entscheidung ihres Gegenübers zu kennen. Menschen entscheiden sich in rund der Hälfte der Fälle fürs Kooperieren und bestraften Eigennutz beim Gegenüber durch Einbehalten des Gewinns in der nächsten Runde. GPT-4 kooperierte dagegen in fast 92 Prozent der Durchgänge.

Menschlich verhielten sich die KI-Systeme auch in ihrer Reaktion auf Framing und Vorerfahrungen: „Wenn wir sie bitten, ihre Entscheidungen zu erklären, oder wenn wir ihnen sagen, dass ihre Entscheidungen von einer dritten Partei begutachtet werden, verhalten sie sich signifikant großzügiger“, berichten Mei und seine Kollegen. Dies war auch der Fall, wenn ChatGPT im Laufe der Durchgänge die Rollen wechselte und so die Perspektive des Gegenübers kennenlernte. Beides ist auch bei uns Menschen der Fall.

Für den weitergehenden Einsatz geeignet

Zusammenfassend kommen Mei und sein Team zu dem Schluss, dass sich die künstlichen Intelligenzen auch bei sozial-strategischen Entscheidungen bemerkenswert menschlich verhalten. Denn obwohl die KI-Systeme weder fühlen noch im engeren Sinne denken können, reagieren sie in ihren Entscheidungen ganz ähnlich wie wir. Nach Ansicht des Teams würden sie sich demnach für den Einsatz auch in potenziell sensiblen Bereichen wie dem Kundendienst, der Konfliktschlichtung oder auch dem Gesundheitswesen eignen.

„Optimistisch macht auch, dass die KI eher in die positive Richtung vom menschlichen Standard abweicht – sie reagiert eher altruistischer und kooperativer“, so das Team. (Proceedings of the National Academy of Sciences (PNAS), 2024; doi: 10.1073/pnas.2313925121)

Quelle: Proceedings of the National Academy of Sciences