Forscher haben ein System entwickelt, mit dem man in Sekundenschnelle aus Texten Bilder erzeugen kann – ohne komplizierte Handhabung oder Hochleistungsrechner. Basis ist ein KI-Modell, das einfache Textanweisungen in detaillierte Bilder umwandeln, die Auflösung unscharfer Fotos erhöhen oder Objekte aus Bildern entfernen kann. Trotz dieser Leistungsfähigkeit ist das Modell nur wenige Gigabyte groß und kann auch mithilfe einer normalen Grafikkarte zum Laufen gebracht werden.

Tiere mit skurriler Bekleidung, Samurai-Krieger auf fremden Planeten oder Albert Einstein im Stil von Picasso gemalt: Computergenerierte Bilder sind im Internet längst keine Seltenheit mehr. Text-zu-Bild-Generatoren wie DALL-E 2 oder Googles Imagen sind sogar in der Lage, einfache Textbeschreibungen in realistische Fotos oder Gemälde umzuwandeln oder nach Textanweisung bereits bestehende Bilder abzuändern.

Basis dieser Technologien ist künstliche Intelligenz in Form neuronaler Netzwerke. Diese werden mit Milliarden von Trainingsbildern gefüttert, durch die sie lernen, das Abgebildete mit Begriffen zu verbinden und zu kategorisieren. Auf dieser Grundlage kann das KI-System dann die Begriffe wiedererkennen und die dazu passenden Abbildungen generieren.

Bilder werden aufgelöst

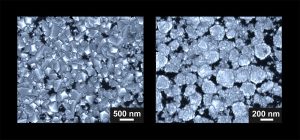

Der aktuell wohl vielversprechendste Codierungsansatz ist dabei eine sogenannte Diffusions-Methode, bei der die Bilder in mehreren Schritten immer weiter verpixelt und dadurch aufgelöst werden, bis nichts mehr von ihnen übrig ist. Während die Komplexität der codierten Pixel immer geringer wird, sorgen die sogenannten Autoencoder des neuronalen Netzes dafür, dass nur die relevantesten Informationen gespeichert werden und der Datensatz so möglichst effizient wird.

„Wenn eine solche KI wirklich verstanden hat, was ein Auto ausmacht oder welche Merkmale für einen künstlerischen Stil charakteristisch sind, sollte sie genau diese wesentlichen Merkmale erfasst haben. Idealerweise kann sie dann weitere Beispiele kreieren, wie es ein Schüler eines alten Meisters vermag“, erklärt Seniorautor Björn Ommer von der Ludwig-Maximilians-Universität München.

Sparsamkeit durch frühe Optimierung

Gemeinsam mit den Erstautoren Robin Rombach und Andreas Blattmann hat Ommer nun ein neues KI-Modell vorgestellt, mit dem die Synthese von Bildern aus Text noch effizienter wird. Der „Stable Diffusion“ getaufte Algorithmus löst dabei das Problem, dass bisherige Generatoren besonders große Rechenpower benötigen, um Bilder zu erzeugen. Das hängt damit zusammen, dass bei ihnen der „Denoising“-Prozess, also die Rückwandlung von verpixeltem Wirrwarr zu hochdetaillierten Fotos, auf der Pixel-Ebene stattfindet. In den nacheinander stattfindenden Durchläufen analysiert der Algorithmus immer wieder das erzeugte Bild und verbessert es anschließend.

Stable Diffusion greift hingegen schon früher, im sogenannten „latent space“, in die Optimierung ein. Der latent space bildet die Ebene vor der letztlichen Bilderstellung, in der die textbasierte Datenbasis und das pixelbasierte Ergebnis zusammengeführt werden. Da diese Zwischenebene deutlich datensparsamer ist als ein fertiges Bild, benötigt auch die Analyse und Optimierung nur einen Bruchteil der Rechenleistung.

Auch von Laien nutzbar

Den Wissenschaftlern gelang es so, ein nur wenige Gigabyte großes KI-Modell zu erschaffen, das auch auf dem heimischen Computer zur Bildgenerierung genutzt werden kann. „Selbst Laien ohne künstlerische Fähigkeiten, besondere Computerkenntnisse oder -hardware erhalten mit dem neuen Modell ein effektives Tool, mit dem sie ihre Kreativität entfalten können. Der Computer kann damit auf einfaches Zurufen hin Bilder generieren“, sagt Ommer.

Neben der Text-zu-Bild-Synthese kann Stable Diffusion – ähnlich wie viele seiner Vorgänger – noch weitere Aufgaben erledigen. Dazu zählt unter anderem die „Super-Auflösung“, die bei einem bereits vorhandenen und meist unscharfen Bild die Auflösung deutlich erhöht. Es können aber auch einzelne Objekte oder Personen aus Bildern entfernt werden – der Algorithmus füllt das Loch dann auf.

Entwicklung findet Open Source statt

Eine weitere Neuerung von Stable Diffusion ist es, dass es Open Source angeboten wird, also jeder den Quellcode frei downloaden kann. Dadurch will das Forscherteam die Entwicklung des Algorithmus weiter vorantreiben. „Wir sind gespannt, was mit unserem aktuellen Modell gebaut wird und welche weiteren Arbeiten aus der offenen, kollaborativen Forschung hervorgehen werden“, sagt Rombach.

Zu den ersten Ideen der KI-Community gehören beispielsweise ein übersichtliches User-Interface oder ein bereits angekündigtes Plugin für Adobe Photoshop, das Künstlern bei ihrer Arbeit unter die Arme greifen soll und „Alpaca“ getauft wurde. Eine aktuelle Beta des Algorithmus’ ist außerdem derzeit unter dem Namen „Dreamstudio“ nutzbar. (Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2022; doi: 10.48550/arXiv.2112.10752)

Quelle: Ludwig-Maximilians-Universität München