Gemeinwohl oder Eigennutz? Hat ein autonomes Fahrzeug einen Unfall, muss es entscheiden: Schützt es seinen Insassen um jeden Preis oder opfert es ihn, um mehrere andere zu retten? Moralisch richtig wäre die Entscheidung zum Wohl der Vielen. Aber in der Praxis ist das weniger simpel, wie nun ein Experiment belegt. Die Lösung dieser ethischen Frage könnte sogar eine der größten Hürden auf dem Weg zum autonomen Verkehr sein, so die Forscher im Fachmagazin „Science“.

Es ist das klassische Dilemma: Darf man einen Menschen töten, um mehrere andere zu retten? Und in welchen Situationen ist dies moralisch vertretbar? Vor die Wahl gestellt, würden die allermeisten Menschen zugunsten der Vielen entschieden – solange sie dafür keinen Mord begehen müssen. Allerdings können Begleitumstände und sogar die Sprache die individuelle Entscheidung deutlich beeinflussen. Glücklicherweise werden wir im Alltag fast nie mit diesem moralischen Dilemma konfrontiert.

Programmiertes Dilemma

Das aber könnte sich in Zukunft ändern. Denn selbstfahrende Autos, die sich autonom durch den Verkehr bewegen, sind bereits seit längerem in der Testphase. Sie gelten als besonders sicher und könnten die Zahl der Verkehrsunfälle um 90 Prozent senken, so die Schätzung von Experten.

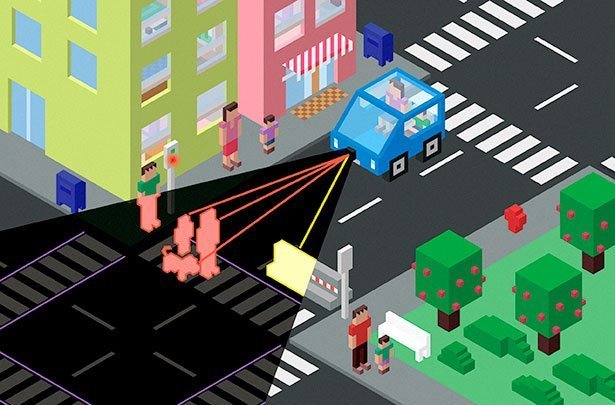

„Aber nicht alle Unfälle können vermieden werden und einige davon werden dem autonomen Fahrzeug schwierige ethische Entscheidungen abverlangen“, erklären Jean- François Bonnefin von der Universität Toulouse und seine Kollegen. Im Ernstfall muss die Software des Fahrzeugs entscheiden, wen es opfert, wenn Fußgänger vor ihm auf die Straße laufen. Fährt es weiter und schützt seinen Insassen oder weicht es aus und riskiert das Leben des Fahrers?

Moral im Szenarien-Test

„Auch wenn ein solches Szenario unwahrscheinlich erscheint, wird es zwangsläufig vorkommen, wenn erst einmal Millionen von autonomen Fahrzeugen auf den Straßen unterwegs sind“, betonen die Forscher. Sie haben daher in Online-Experimenten mit knapp 2.000 Testpersonen untersucht, welche Entscheidung sie bei verschiedenen Unfall-Szenarien für richtig halten.

Der Clou dabei: Die Teilnehmer sollten ihre Bewertungen in einigen Fällen als unbeteiligte Beobachter abgeben, in anderen sollten sie sich vorstellen, selbst Insasse des autonomen Fahrzeugs zu sein. Außerdem wollten die Forscher wissen, welche Programmierung sich die Versuchspersonen für ihr eigenes autonomes Fahrzeug wünschen würden.

Im Zweifelsfall für die Mehrheit

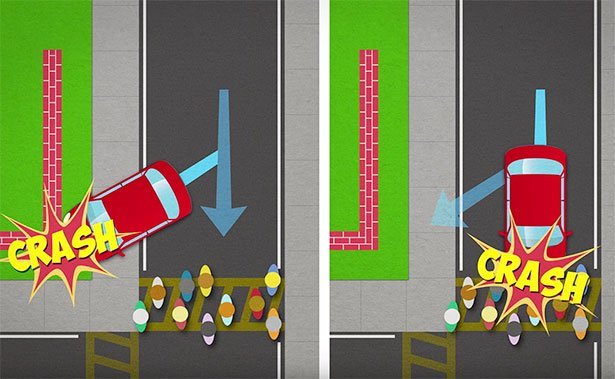

Das Ergebnis: „Eine deutliche Mehrheit der Teilnehmer zeigte eine moralische Präferenz für ein Vehikel, das auf die Minimierung der Opfer programmiert ist“, berichten Bonnefin und seine Kollegen. Im Szenario mit zehn Fußgängern und einem Autofahrer entschieden sich 76 Prozent dafür, den Fahrer zugunsten der Fußgänger zu opfern. Je höher die Zahl der geretteten Fußgänger, desto mehr waren für diese rationale moralische Entscheidung.

Das Wohl der Mehrheit wählten die meisten Teilnehmer selbst dann, wenn sie aus der Perspektive des Insassen entschieden. Sogar wenn ein Familienmitglied mitbetroffen wäre und ebenfalls zum Wohl der Mehrheit sterben würde, war eine knappe Mehrheit dafür, wie die Forscher berichten. Anders sah dies erwartungsgemäß nur dann aus, wenn ein Fahrer einem Fußgänger gegenüberstand: Hier fanden es nur 23 Prozent der Teilnehmer richtig, den Fahrer zu opfern.

Moral endet beim Kauf

Entlarvend war jedoch die Frage nach der eigenen Kaufvorliebe, denn dabei siegte doch Eigennutz über Moral: Die meisten Teilnehmer würden lieber ein autonomes Auto kaufen, das auf maximalen Schutz der Insassen programmiert ist – egal wie viele Fußgänger beim Unfall sterben müssten. Während solche „egoistischen Autos“ verboten, würde nur noch ein Drittel der Teilnehmer überhaupt ein selbstfahrendes Auto kaufen.

„Das zeigt das moralische Dilemma des autonomen Fahrens“, erklären die Forscher: „Zwar sind die Menschen sich darin einig, dass es für alle besser wäre, wenn die Fahrzeuge auf eine Minimierung der Opfer programmiert sind. Dennoch ziehen sie es selbst vor, in Autos zu fahren, die sie unter allen Umständen schützen.“

„Es gibt keinen einfachen Weg“

Für die Autohersteller, Programmierer und Regierungen ist dies eine Zwickmühle, wie Bonnefin und seine Kollegen betonen: Bauen sie autonome Fahrzeuge, die moralisch und zum Wohl der Mehrheit reagieren, werden diese unter Umständen nicht gekauft. Das könnte die Einführung solcher Fahrzeuge verzögern und damit zu vielen unnötigen Unfällen führen. Wird dies jedoch nicht einheitlich geregelt, könnten die Straßen zu einer Zone egoistisch agierender Roboterfahrzeuge werden.

„Herauszufinden, wie man am besten autonome und ethische Maschinen konstruiert, ist eine der dornigsten Herausforderungen der künstlichen Intelligenz“, konstatieren die Forscher. „Im Moment scheint es keinen einfachen Weg zu Algorithmen zu geben, die moralische Werte und das persönliche Eigeninteresse miteinander versöhnen.“ Die Lösung dieses Dilemmas sei daher eine der dringendsten Fragen bei der Entwicklung autonomer Fahrzeuge. (Science, 2016; doi: 10.1126/science.aaf2654)

(AAAS, 24.06.2016 – NPO)