Blick auf den Mund: Wenn wir jemandem zuhören, blicken wir instinktiv auf seinen Mund – das hilft uns auch beim Verstehen. Jetzt zeigt ein Experiment: Dieses „Hören mit den Augen“ ist zwar typisch für uns Europäer, nicht aber für Asiaten. Japaner verstehen das Gesagte sogar schlechter, wenn sie gleichzeitig auf Lippenbewegungen achten, wie Forscher im Fachmagazin “ Scientific Reports“ berichten.

Wenn wir jemandem intensiv zuhören, blicken wir ihm meist ins Gesicht. Denn Mimik, aber auch Lippenbewegungen helfen uns, das Gesagte zu verstehen. Gerade bei Silben, die akustisch sehr ähnlich klingen oder aber in einem lauten Raum mit vielen Störgeräuschen, kann die Lippenstellung das Verständnis erleichtern. Umgekehrt sorgt es bei uns oft für Irritation, wenn ein Film schlecht synchronisiert ist und Mundbewegungen und Sprache nicht übereinstimmen.

Japaner und Briten im Test

Ob diese Effekte auch bei Japanern auftreten, haben nun Satoko Hisanaga von der Kumamoto Universität und seine Kollegen in einem Experiment untersucht. Für ihre Studie spielten sie jeweils 20 englischen und 20 japanischen Muttersprachlern Videos vor, in denen Europäerin oder eine Japanerin akustisch sehr ähnliche Silben sprach, beispielsweise „ba“ und „ga“.

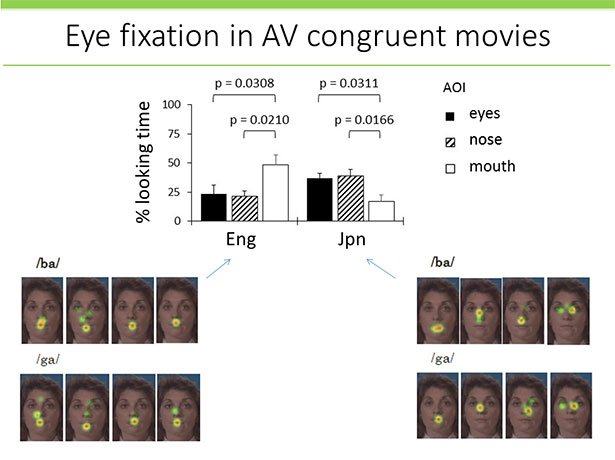

Durch Eyetracker, Ableitungen der Hirnströme und Hirnscans ermittelten die Forscher, wie stark die Probanden den Mund der Sprecherin fixierten und welche Hirnareale bei der Sprachverarbeitung beteiligt waren. Außerdem verglichen sie, wie häufig und wie schnell die Teilnehmer die Silbe richtig bestimmten. In einige Durchgängen wurden die Videos zudem so manipuliert, dass Mundbewegungen und Silbe nicht zueinander passten.

Sehen verlangsamt Hörreaktion

Das verblüffende Ergebnis: Die englischsprachigen Probanden nannten die richtige Silben schneller und häufiger, wenn sie gleichzeitig zum Ton die sprechende Frau sahen. Bei den Japanern jedoch war es umgekehrt: Sie benötigten mehr Zeit, wenn sie sich auf Video und Ton gleichzeitig konzentrieren mussten, wie die Forscher berichten.

Hörten die japanischen Probanden nur die Silben allein, verstanden sie das Gesprochene schneller. Nach Ansicht der Forscher könnte das erklären, warum Japaner eine Fremdsprache besser durch das reine Hören lernen und von Sprachvideos nur wenig profitieren. Bei Europäern ist der Lernerfolg dagegen meist größer, wenn sie den Sprechenden sehen können.

Blick auf den Mund nur bei Europäern

Und noch ein Unterschied zeigte sich im Experiment: Die Europäer konzentrierten ihren Blick fast immer auf den Mund der Frau im Video – und das schon bevor diese zu sprechen begann. Bei den Japanern hingegen schweifte der Blick im Gesicht umher und blieb weit häufiger an Nase und Augen hängen, wie die Eyetracker-Daten ergaben.

„Englischsprachige Menschen versuchen, die mögliche Laute einzuengen, indem sie die Information der Lippenbewegungen nutzen“, erklärt Seniorautor Kaoru Sekiyama von der Kumamoto Universität. „Japanische Muttersprachler dagegen legen ihren Schwerpunkt auf das reine Hören – die visuelle Information erfordert einen zusätzlichen Verarbeitungsaufwand.“ Das erklärt auch, warum Europäer eher irritiert sind, wenn Laute und Bewegungen bei einem Video nicht zusammenpassen.

Hirnareale bei Europäern enger verknüpft

In einem weiteren Versuchsdurchgang testeten die Forscher, ob diese Unterschiede sich auch in der Verdrahtung des Gehirns widerspiegeln. Dafür zeichneten sie die Hirnaktivität der Probanden mittels funktioneller Magnetresonanz-Tomografie (fMRT) auf.

Und tatsächlich: Bei den Europäern waren die Hirnareale für das Hören und für die Verarbeitung visueller Information eng funktionell miteinander verknüpft. Die primäre Hörrinde und Bereiche im Temporallappen feuerten gemeinsam, wenn die Probanden die Silben hörten und Videos sahen. Anders bei den Japanern: Bei ihnen war diese Verknüpfung deutlich schwächer ausgeprägt, wie die Forscher berichten.

Art der Sprachverarbeitung ist nicht universell

„Unsere Ergebnisse belegen, dass die neuronalen Prozesse bei der audiovisuellen Sprachverarbeitung nicht universell sind“, konstatieren Hisanaga und seine Kollegen. Stattdessen prägen offenbar die kulturellen Eigenheiten, ob jemand nur auf das Gehörte achtet oder auch visuelle Informationen hinzunimmt.

Gestützt wird dies durch die Beobachtung, dass die Unterschiede in der Sprachverarbeitung erst bei Kindern im Alter von sechs bis acht Jahren auftreten. Vorher ähneln sich die neuronalen Prozesse bei Europäern und Japaner stark. „Unser Verhalten und unsere neuronale Reaktion bei der Verarbeitung gehörter und gesehener Sprache werden offensichtlich durch unseren linguistischen und kulturellen Hintergrund definiert“, sagen die Forscher. (Scientific Reports, 2016; doi: 10.1038/srep35265)

(Kumamoto University, 17.11.2016 – NPO)