Die hohe, helle Halle ist von leisem Rauschen erfüllt. Um uns herum bilden eingehauste Doppelreihen von Serverschränken ein geordnetes Gängelabyrinth. Wir befinden uns im digitalen Herzen des CERN – dem Rechenzentrum. Das CERN ist nicht umsonst die Geburtsstätte des World Wide Web: Ohne Computer und vor allem schnelle Datenverbindungen wären die Detektoren, Auswertungen und letztlich auch die Entdeckung des Higgs-Teilchens unmöglich. Kein Wunder also, dass das Rechnerzentrum und auch das GRID – das weltweite Netz, über das die LHC-Daten verteilt und verarbeitet werden, zum leistungsfähigsten gehören, was es weltweit in diesem Bereich gibt.

Nur potenziell Spannendes kommt durch

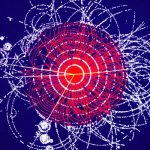

Denn wenn es um Daten geht, haben die IT-Experten des CERN gleich zwei Probleme: Zum einen erzeugt jeder der Detektoren am LHC gewaltige Mengen an Rohdaten. Pro Sekunde sind dies allein beim ATLAS-Detektor ein Petabyte – viel zu viel, um sie alle zu speichern und zu verarbeiten. Tatsächlich passiert dies auch nicht, wie uns Andreas Wagner vom CERN-Rechenzentrum erklärt. Stattdessen wird gesiebt: Ausgehend von theoretischen Modellen und Simulationen weiß man ungefähr, wie die Teilchenspuren und Signale aussehen, die von physikalisch spannenden Ereignissen erzeugt werden – wie beispielsweise dem Zerfall des Higgs-Bosons. Zudem gilt alles als „lohnend“, was sehr schwere Teilchen und energiereiche Zerfallsprodukte hinterlässt, weil sich dort beispielsweise Indizien für noch unbekannte Bausteine der Materie verbergen könnten.

Die Parameter dieser potenziell spannenden Kollisionen und ihrer Produkte sind- für jeden Detektor spezifisch – in spezielle Filterprogramm eingespeist, die sogenannten Trigger. Diese filtern dann alle Daten von „0815-Kollisionen“ heraus. Zusätzlich allerdings übernehmen sie auch nach dem Zufallsprinzip ausgewählte Ereignisse, die den Filterparametern nicht entsprechen. Denn: „Auch Theoretiker sind nur Menschen, man darf daher nicht vernachlässigen, was nicht vorhergesagt ist“, betont CERN-Generaldirektor Rolf Heuer. Denn gerade dort, wo das gängige Standardmodell der Physik seine Grenzen hat, schließen die Physiker nicht aus, dass auch ganz unerwartete Wechselwirkungen und Teilchen auftreten können.

Nach diesem Filterdurchgang bleiben noch immer gigantische Datenmengen übrig: Pro Jahr generieren die vier großen Detektoren am LHC rund 30 Petabytes – das ist genug, um einen DVD-Stapel von 40 Kilometern Höhe zu füllen. Im Rechenzentrum des CERN werden diese Rohdaten größtenteils auf Magnetbändern gespeichert, ein Teil wird auch auf den rund 70.00 Festplatten der rund 9.00 Server quasi griffbereit vorgehalten. Braucht ein Physiker dann Daten, die auf einem Band gelagert sind, sorgen die in der automatischen Bandbibliothek integrierten Roboterarme dafür, dass er innerhalb von nur fünf bis zehn Minuten Zugriff erhält.

Weltweit vernetzt

Aber es gibt noch ein weiteres Problem: Die Physiker, die die LHC-Daten auswerten, sitzen größtenteils nicht vor Ort, sondern sind über die ganze Welt verteilt. Allein die ATLAS-Kollaboration umfasst mehr als 3.000 Wissenschaftler auf allen Kontinenten außer der Antarktis. „In den 1980er Jahren haben wir noch gedacht, dass wir die Bänder mit den Daten per Flugzeug transportieren müssen, wenn das US-Forschungszentrum Fermilab welche braucht“, erzählt Wagner. Dank Tim Berners-Lee, der in seiner Zeit am CERN das WWW erfand, und den immer schneller werdenden Datenverbindungen haben sich diese Befürchtungen allerdings als hinfällig erwiesen. „Der technische Fortschritt hat in dieser Hinsicht unsere Erwartungen übererfüllt.“

Um die Daten auszutauschen, aber auch überhaupt die Kapazität zu haben, sie verarbeiten und analysieren zu können, haben die IT-Leute vom CERN das Worldwide LHC Computing Grid (WLCG) entwickelt. Dieses in mehrere Ebenen gegliederte Datennetz besteht aus insgesamt rund 170 Rechenzentren in 34 Ländern und über 100.000 Prozessoren. Während die obersten Ebene, das am CERN angesiedelte Tier-0, nur die Rohdaten speichert, übernehmen die zehn über schnelle Forschungsnetze angeschlossenen Tier-1-Zentren die Datenverteilung und dienen gleichzeitig als Sicherheitskopie. Die eigentlichen Berechnungen und Analysen werden dann von den rund 150 Tier-2-Zentren an Forschungsinstituten und Universitäten in 38 Ländern geleistet.

Auch Hacker mögen das CERN

Natürlich macht sich ein so verteiltes Netz auch angreifbar, Hackerangriffe hat es auch beim CERN schon einige gegeben, wie Wagner einräumt. Bisher sei aber keine erfolgreich gewesen.

„Der Schutz ist besonders schwierig, weil viele Physiker sowohl vom CERN selbst als auch von ganz woanders aus auf ihre Daten zugreifen wollen – und das meist mit dem gleichen Passwort.“ Und das Netz gegen unbefugte Eindringlinge und Viren zu sichern, werden unter anderem alle externen Zugriffe aufgezeichnet, das Kopieren oder Austauschen von Daten ist blockiert und vier Leute sind allein für die Sicherheit des Systems zuständig, wie der IT-Experte erklärt.

Und noch eine Sicherheitsmaßnahme gilt: Alle für den Betrieb des LHC und der Detektoren nötigen Systeme sind vom restlichen Netz abgekoppelt. „Sie sind von außen komplett unsichtbar“, sagt Wagner. Die wenigen noch bestehenden Verbindungen zum internen CERN-Netz lassen sich zudem innerhalb von Minuten trennen – um zu verhindern, dass Schadsoftware oder Hacker Zugriff auf diese sensiblen Systeme erhalten. Priorität haben diese Steuersysteme auch, wenn im Rechenzentrum der Strom ausfällt: Dann sorgen Batterien und eigene Notstrom-Diesel-Aggregate dafür, dass diese essenziellen Rechner weiterlaufen. „Komplett abgeschaltet war das Rechenzentrum allerdings noch nie“, sagt Wagner.

Nadja Podbregar

Stand: 02.08.2013